0. 背景 : 参数量与架构的祛魅

在 2025 年的 LLM (大语言模型) 战场,单纯的“参数军备竞赛”已成过去式。现在的核心架构已从单体稠密模型 (Dense) 全面转向 MoE (Mixture of Experts,混合专家),并衍生出 System 2 (推理/思考) 和 Native Multimodal (原生多模态) 两个新分支。

作为技术负责人,在选型时必须透过营销代号(如 Flash, Pro, Ultra),看透其背后的 Total B (总参数) 和 Active A (激活参数),才能在显存成本、推理延迟和业务效果之间找到最优解。

1. 字段解密 : 读懂模型 ID 的核心指标

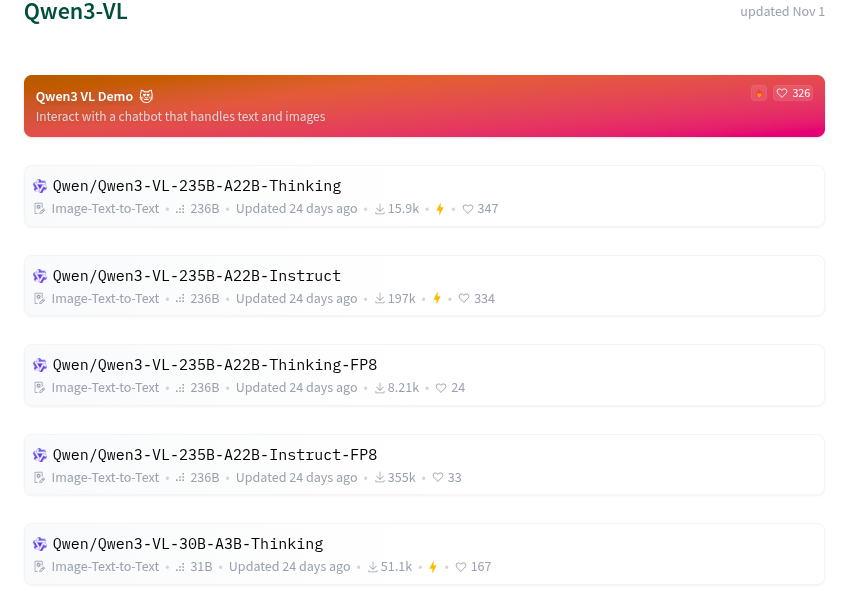

以 Qwen3-VL-235B-A22B-Thinking-FP8 这种典型的 2025 年模型命名为例,拆解其技术含义。

1.1 核心参数:B (Total) vs A (Active)

这是 MoE 架构下最重要的两个指标,直接决定硬件采购成本。

- 235B (Total Parameters / 总参数量)

- 定义:模型的“脑容量”上限,包含所有的专家网络(Experts)。

- 硬件影响:决定显存 (VRAM) 门槛。无论推理时用不用,这 235B 参数必须全部加载到显存(或内存 Offload)中。

- 能力映射:决定知识广度、冷门知识召回率、复杂逻辑的潜在上限。

- A22B (Active Parameters / 激活参数量)

- 定义:处理单个 Token 时,路由网关(Router)实际调用的专家参数量。

- 硬件影响:决定算力 (Compute) 消耗与延迟 (Latency)。虽然模型很大,但每次计算只跑 22B 的量。

- 能力映射:决定并发吞吐量 (TPS) 和响应速度。

架构师视角:

235B-A22B意味着你需要买 H800/A100 集群来存它(显存大),但它的推理速度却像 30B 模型一样快(计算量小)。这是“用空间换时间”的典型策略。

1.2 功能后缀变体

- Instruct (指令版):最通用的版本。经过 SFT (监督微调) 和 RLHF,听得懂人话,适合客服、翻译、RAG。

- Thinking / Reasoning (思考版):类似 OpenAI o1。在输出最终答案前,会强制生成一段“思维链 (Chain of Thought)”。

- 特点:推理慢,Token 消耗大,但逻辑、数学、代码能力极强。

- FP8 / Int4 (量化版):模型经过 8-bit 或 4-bit 压缩。

- 特点:显存占用减半甚至更低,精度损失极小(大模型通常可忽略),生产环境首选。

2. 战场盘点 : 2025 年主流模型参数底牌

基于 2025 Q4 的技术情报,各家厂商策略分化明显:xAI 堆参数,Google 拼多模态,OpenAI 拼逻辑推理。

2.1 xAI Grok 系列:暴力美学

马斯克坚持“力大砖飞”,Grok 是目前已知参数量最大的单体/MoE 模型。

| 型号 | 总参数 (Total) | 架构特点 | 适用场景 |

|---|---|---|---|

| Grok-3 | ~2.7T (2700B) | 128 Experts MoE | 百科全书。当业务需要极度冷门的物理、历史知识,或极长的上下文记忆时使用。显存开销极大。 |

| Grok-2 | ~270B | MoE (Active ~115B) | 中规中矩的旗舰,适合需要强逻辑但没资源跑 Grok-3 的场景。 |

2.2 Google Gemini 系列:多模态与思考

Google 策略是“原生多模态”和“长窗口 (2M Context)”。

| 型号 | 预估参数 | 核心竞争力 | 适用场景 |

|---|---|---|---|

| Gemini 2.5 Pro | ~400B | Thinking Model | 逻辑主力。自带深度思考能力,且原生支持视频/音频输入。适合复杂多模态任务分析。 |

| Gemini 2.0 Flash | ~30B | Latency King | 实时交互。极快的响应速度,适合语音助手、视频流实时理解。性价比极高。 |

2.3 OpenAI GPT 系列:System 2 推理革命

OpenAI 放弃了单纯堆参数,转向优化“推理时计算” (Inference-time Compute)。

| 型号 | 预估参数 | 核心竞争力 | 适用场景 |

|---|---|---|---|

| o1 (Full) | ~200B | 强化学习 (RL) | 理科怪兽。参数不大,但通过 RL 训练学会了自我纠错。做高难度算法题、架构设计首选。 |

| o1-mini | ~100B | 蒸馏版 | 代码专精。砍掉了文科知识,保留了逻辑能力。写代码性价比最高。 |

| GPT-4o | ~200B | 综合平衡 | 基准线。万金油,如果你不知道选什么,选它不会错,但逻辑上限不如 o1。 |

3. 选型指南 : 业务场景与参数的映射

在实际架构设计中,不要只买贵的,要买对的。请参考以下分工矩阵:

场景 A:核心逻辑与复杂代码 (Reasoning Heavy)

- 需求:算法优化、复杂架构设计、数学证明、法律合同审核。

- 特征:允许延迟(等几秒没关系),但要求结果绝对准确,逻辑严密。

- 推荐模型:

- OpenAI o1 / o1-mini

- Gemini 2.5 Pro (Thinking)

- Qwen3-Thinking

- 避坑:不要用 Flash 或 Mini 类模型,也不要用单纯参数大但没经过 CoT 强化的旧模型。

场景 B:海量知识与长文档分析 (Knowledge Heavy)

- 需求:回答“18世纪的某个冷门历史细节”、分析 500 页的 PDF、全库代码检索。

- 特征:需要巨大的“静态知识库”和超长上下文窗口。

- 推荐模型:

- Grok-3 (2.7T):知识储备最强。

- Gemini 1.5/2.5 Pro:200万 Token 窗口是目前处理长文档的最优解。

- 策略:这里 Total B 是关键指标,参数越大,幻觉(胡说八道)概率相对越低。

场景 C:高并发实时服务 (Real-time Serving)

- 需求:智能客服、RAG 的最后一步生成、即时翻译、NPC 对话。

- 特征:对首字延迟 (TTFT) 极度敏感,成本敏感。

- 推荐模型:

- Gemini 2.0 Flash

- GPT-4o mini

- Qwen3-30B-A3B

- 策略:关注 Active A。A 越小,速度越快。A3B (激活30亿) 的模型在 T4/A10 上也能跑得飞快。

场景 D:私有化/端侧部署 (On-Prem/Edge)

- 需求:数据不出域、运行在笔记本/手机/车载芯片上。

- 推荐模型:

- Qwen 14B / 32B (需量化为 Int4)

- Llama 3.x 8B

- Gemini Nano

- 策略:必须看 Total B,显存是硬伤。例如 4090 显卡 (24G 显存) 极限只能跑 30B 左右的 Int4 模型。

总结

- 看 B (Total):确定你的显卡能不能装下,以及它懂不懂冷门知识。

- 看 A (Active):确定它跑得快不快,电费贵不贵。

- 看后缀 (Thinking):确定它是用来“干活”的(写代码/算数),还是用来“聊天”的。

发表回复